Associate-Developer-Apache-Spark-3.5 문제 21

55개 중 40개.

개발자는 Spark 3.5에 도입된 기본 제공 함수를 활용하기 위해 기존 Spark 코드를 리팩토링하려고 합니다.

원래 코드:

pyspark.sql에서 함수를 F로 가져오기

최소가격 = 110.50

result_df = prices_df.filter(F.col("price") > min_price).agg(F.count("*")) 개발자는 어떤 코드 블록을 사용하여 코드를 리팩토링해야 합니까?

개발자는 Spark 3.5에 도입된 기본 제공 함수를 활용하기 위해 기존 Spark 코드를 리팩토링하려고 합니다.

원래 코드:

pyspark.sql에서 함수를 F로 가져오기

최소가격 = 110.50

result_df = prices_df.filter(F.col("price") > min_price).agg(F.count("*")) 개발자는 어떤 코드 블록을 사용하여 코드를 리팩토링해야 합니까?

Associate-Developer-Apache-Spark-3.5 문제 22

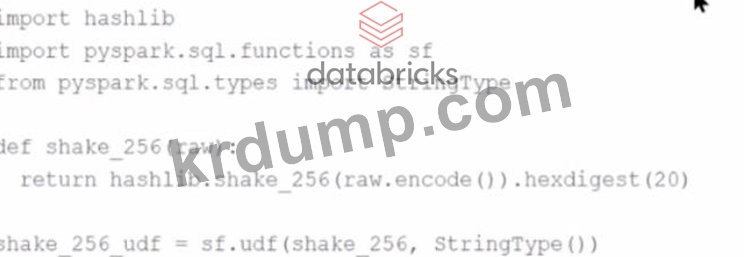

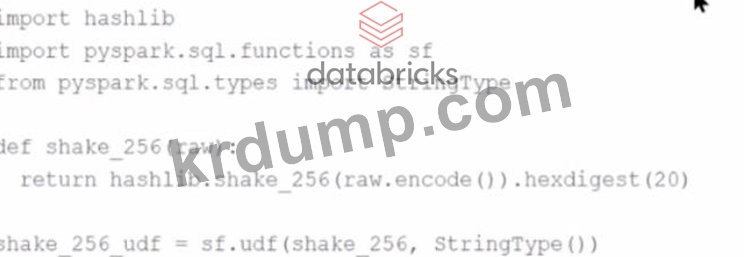

Spark 개발자는 표준 Spark 함수 라이브러리에서 사용할 수 없는 해시 함수를 실행하는 기존 PySpark UDF의 성능을 개선하고자 합니다. 기존 UDF 코드는 다음과 같습니다.

hashlib 가져오기

pyspark.sql.functions를 sf로 가져오기

pyspark.sql.types에서 StringType 가져오기

def shake_256(원시):

hashlib.shake_256(raw.encode()).hexdigest(20)을 반환합니다.

shake_256_udf = sf.udf(shake_256, StringType())

개발자는 성능 향상을 위해 기존 UDF를 Pandas UDF로 대체하려고 합니다. 개발자는 shake_256_udf의 정의를 다음과 같이 변경합니다. CopyEdit shake_256_udf = sf.pandas_udf(shake_256, StringType()) 하지만 개발자는 다음과 같은 오류를 받습니다.

이 오류를 해결하려면 shake_256() 함수의 서명을 어떻게 변경해야 합니까?

hashlib 가져오기

pyspark.sql.functions를 sf로 가져오기

pyspark.sql.types에서 StringType 가져오기

def shake_256(원시):

hashlib.shake_256(raw.encode()).hexdigest(20)을 반환합니다.

shake_256_udf = sf.udf(shake_256, StringType())

개발자는 성능 향상을 위해 기존 UDF를 Pandas UDF로 대체하려고 합니다. 개발자는 shake_256_udf의 정의를 다음과 같이 변경합니다. CopyEdit shake_256_udf = sf.pandas_udf(shake_256, StringType()) 하지만 개발자는 다음과 같은 오류를 받습니다.

이 오류를 해결하려면 shake_256() 함수의 서명을 어떻게 변경해야 합니까?

Associate-Developer-Apache-Spark-3.5 문제 23

Spark 클러스터와의 원격 상호작용을 가능하게 하는 애플리케이션을 설계할 때 Spark Connect의 어떤 기능이 고려됩니까?

Associate-Developer-Apache-Spark-3.5 문제 24

55개 중 43개.

어떤 조직에서는 프로덕션 환경에서 Spark 애플리케이션을 실행하고 있으며 리소스 사용량을 줄이기 위해 Spark History Server를 비활성화하는 것을 고려하고 있습니다.

프로덕션 환경에서 Spark History Server를 비활성화하면 어떤 영향이 있을까요?

어떤 조직에서는 프로덕션 환경에서 Spark 애플리케이션을 실행하고 있으며 리소스 사용량을 줄이기 위해 Spark History Server를 비활성화하는 것을 고려하고 있습니다.

프로덕션 환경에서 Spark History Server를 비활성화하면 어떤 영향이 있을까요?

Associate-Developer-Apache-Spark-3.5 문제 25

데이터 과학자는 고객 정보가 포함된 customerDF라는 Spark DataFrame을 사용하고 있습니다.

DataFrame에는 고객 이메일 주소가 포함된 email이라는 열이 있습니다. 데이터 과학자는 이 열을 사용자 이름과 도메인 부분으로 분할해야 합니다.

어떤 코드 조각이 이메일 열을 사용자 이름과 도메인 열로 분할합니까?

DataFrame에는 고객 이메일 주소가 포함된 email이라는 열이 있습니다. 데이터 과학자는 이 열을 사용자 이름과 도메인 부분으로 분할해야 합니다.

어떤 코드 조각이 이메일 열을 사용자 이름과 도메인 열로 분할합니까?