Associate-Developer-Apache-Spark-3.5 문제 36

데이터 과학자는 DataFrame의 각 레코드에 다음이 포함되기를 원합니다.

첫 번째 코드 시도는 텍스트 파일을 읽지만, 각 레코드는 한 줄로 구성됩니다. 이 코드는 아래와 같습니다.

파일의 전체 내용

전체 파일 경로

문제: 파일별로 전체 텍스트를 읽는 것이 아니라 줄별로 읽는 것입니다.

암호:

코퍼스 = spark.read.text("/데이터셋/raw_txt/*") \

.select('*','_메타데이터.파일_경로')

어떤 변경을 하면 파일당 하나의 레코드가 보장됩니까?

옵션:

첫 번째 코드 시도는 텍스트 파일을 읽지만, 각 레코드는 한 줄로 구성됩니다. 이 코드는 아래와 같습니다.

파일의 전체 내용

전체 파일 경로

문제: 파일별로 전체 텍스트를 읽는 것이 아니라 줄별로 읽는 것입니다.

암호:

코퍼스 = spark.read.text("/데이터셋/raw_txt/*") \

.select('*','_메타데이터.파일_경로')

어떤 변경을 하면 파일당 하나의 레코드가 보장됩니까?

옵션:

Associate-Developer-Apache-Spark-3.5 문제 37

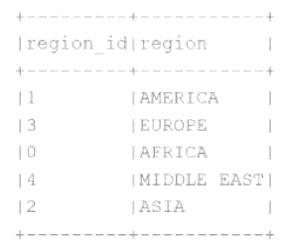

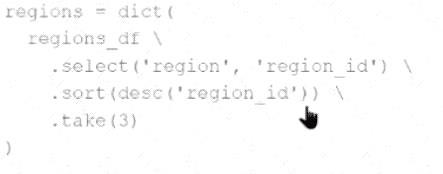

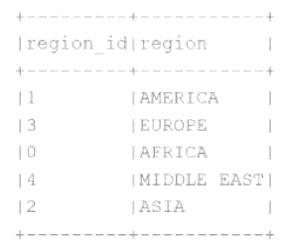

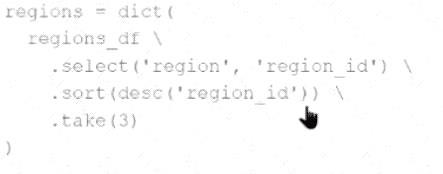

개발자는 다음과 같은 작은 Parquet 테이블에 저장된 데이터를 사용하여 Python 사전을 생성해야 합니다.

결과적으로 생성되는 Python 사전에는 가장 작은 3개의 region_id 값을 포함하는 region-> region id 매핑이 포함되어야 합니다.

어떤 코드 조각이 요구 사항을 충족합니까?

에이)

비)

기음)

디)

결과 Python 사전에는 가장 작은 region -> region_id에 대한 매핑이 포함되어야 합니다.

3region_id 값.

어떤 코드 조각이 요구 사항을 충족합니까?

결과적으로 생성되는 Python 사전에는 가장 작은 3개의 region_id 값을 포함하는 region-> region id 매핑이 포함되어야 합니다.

어떤 코드 조각이 요구 사항을 충족합니까?

에이)

비)

기음)

디)

결과 Python 사전에는 가장 작은 region -> region_id에 대한 매핑이 포함되어야 합니다.

3region_id 값.

어떤 코드 조각이 요구 사항을 충족합니까?

Associate-Developer-Apache-Spark-3.5 문제 38

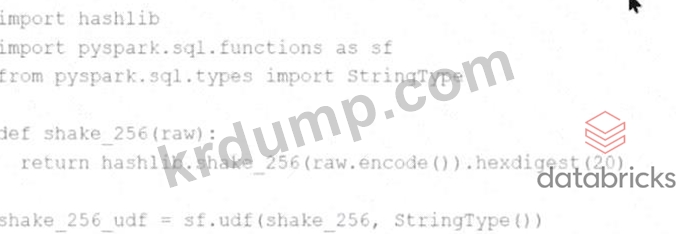

Spark 개발자는 표준 Spark 함수 라이브러리에서 사용할 수 없는 해시 함수를 실행하는 기존 PySpark UDF의 성능을 개선하고자 합니다. 기존 UDF 코드는 다음과 같습니다.

hashlib 가져오기

pyspark.sql.functions를 sf로 가져오기

pyspark.sql.types에서 StringType 가져오기

def shake_256(원시):

hashlib.shake_256(raw.encode()).hexdigest(20)을 반환합니다.

shake_256_udf = sf.udf(shake_256, StringType())

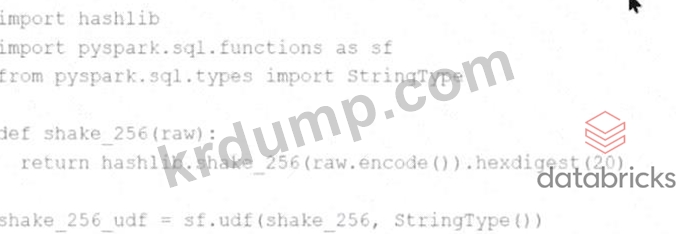

개발자는 성능 향상을 위해 기존 UDF를 Pandas UDF로 대체하려고 합니다. 개발자는 shake_256_udf의 정의를 다음과 같이 변경합니다. 복사 편집 shake_256_udf = sf.pandas_udf(shake_256, StringType()) 하지만 개발자는 다음과 같은 오류를 받습니다.

이 오류를 해결하려면 shake_256() 함수의 서명을 어떻게 변경해야 합니까?

hashlib 가져오기

pyspark.sql.functions를 sf로 가져오기

pyspark.sql.types에서 StringType 가져오기

def shake_256(원시):

hashlib.shake_256(raw.encode()).hexdigest(20)을 반환합니다.

shake_256_udf = sf.udf(shake_256, StringType())

개발자는 성능 향상을 위해 기존 UDF를 Pandas UDF로 대체하려고 합니다. 개발자는 shake_256_udf의 정의를 다음과 같이 변경합니다. 복사 편집 shake_256_udf = sf.pandas_udf(shake_256, StringType()) 하지만 개발자는 다음과 같은 오류를 받습니다.

이 오류를 해결하려면 shake_256() 함수의 서명을 어떻게 변경해야 합니까?

Associate-Developer-Apache-Spark-3.5 문제 39

55개 중 22개.

Spark 애플리케이션은 파일 스키마가 서로 다르지만 호환되는 디렉토리에서 여러 개의 Parquet 파일을 읽어야 합니다.

데이터 엔지니어는 모든 파일의 모든 열을 포함하는 DataFrame을 만들고 싶어합니다.

데이터 엔지니어는 Apache Spark를 사용하여 Parquet 파일을 읽고 모든 열을 포함하기 위해 어떤 코드를 사용해야 합니까?

Spark 애플리케이션은 파일 스키마가 서로 다르지만 호환되는 디렉토리에서 여러 개의 Parquet 파일을 읽어야 합니다.

데이터 엔지니어는 모든 파일의 모든 열을 포함하는 DataFrame을 만들고 싶어합니다.

데이터 엔지니어는 Apache Spark를 사용하여 Parquet 파일을 읽고 모든 열을 포함하기 위해 어떤 코드를 사용해야 합니까?

Associate-Developer-Apache-Spark-3.5 문제 40

금융 서비스 회사의 데이터 과학자가 거래 레코드가 포함된 Spark DataFrame을 사용하고 있습니다. 이 DataFrame은 수백만 개의 행과 transaction_id, account_number, transaction_amount, timestamp 열로 구성되어 있습니다. 소스 시스템의 문제로 인해 일부 거래가 모든 필드에 걸쳐 동일한 정보로 실수로 여러 번 기록되었습니다. 데이터 과학자는 정확한 재무 보고를 위해 모든 필드에서 중복된 행을 제거해야 합니다.

데이터 과학자는 PySpark를 사용하여 주문 중복을 제거하기 위해 어떤 접근 방식을 사용해야 합니까?

데이터 과학자는 PySpark를 사용하여 주문 중복을 제거하기 위해 어떤 접근 방식을 사용해야 합니까?