Associate-Developer-Apache-Spark-3.5 문제 41

55개 중 10개.

Spark에서 데이터 변환을 위해 Pandas API를 사용하면 어떤 이점이 있나요?

Spark에서 데이터 변환을 위해 Pandas API를 사용하면 어떤 이점이 있나요?

Associate-Developer-Apache-Spark-3.5 문제 42

개발자는 데이터 세트의 모든 셔플 이후 파티션이 spark.sql에 설정된 값보다 작다는 것을 알아챘습니다.

적응형.최대 셔플드해시조인로컬맵임계값.

이 경우 적응형 쿼리 실행(AQE)은 어떤 유형의 조인을 선택할까요?

적응형.최대 셔플드해시조인로컬맵임계값.

이 경우 적응형 쿼리 실행(AQE)은 어떤 유형의 조인을 선택할까요?

Associate-Developer-Apache-Spark-3.5 문제 43

다음 뷰 정의가 주어졌습니다.

df.createOrReplaceTempView("users_vw")

세션이 종료된 후 users_vw 뷰를 쿼리하는 데 사용할 수 있는 접근 방식은 무엇입니까?

옵션:

df.createOrReplaceTempView("users_vw")

세션이 종료된 후 users_vw 뷰를 쿼리하는 데 사용할 수 있는 접근 방식은 무엇입니까?

옵션:

Associate-Developer-Apache-Spark-3.5 문제 44

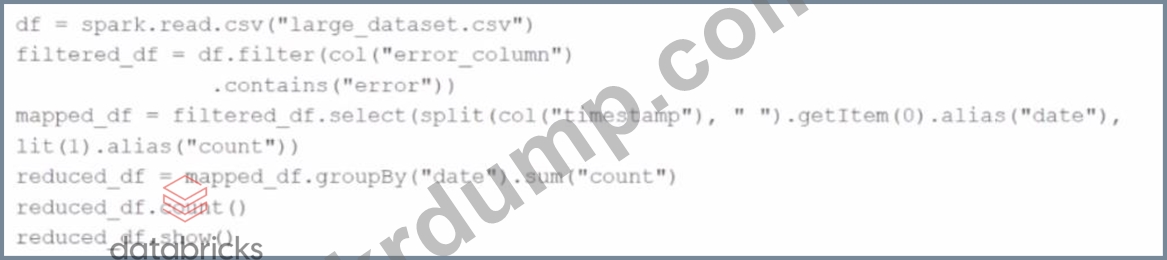

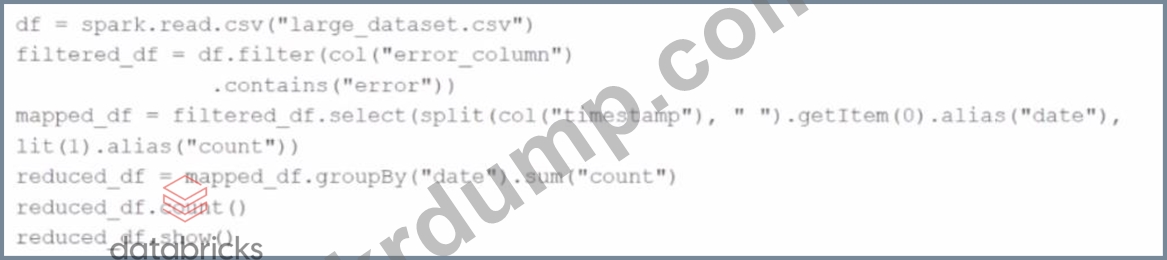

주어진 코드:

df = spark.read.csv("대형 데이터셋.csv")

필터링된_df = df.filter(col("오류_열").포함("오류"))

mapped_df = filtered_df.select(split(col("timestamp"), " ").getItem(0).alias("date"), lit(1).alias("count")) reduced_df = mapped_df.groupBy("date").sum("count") reduced_df.count() reduced_df.show() Spark는 실제로 어느 시점에서 데이터 처리를 시작할까요?

df = spark.read.csv("대형 데이터셋.csv")

필터링된_df = df.filter(col("오류_열").포함("오류"))

mapped_df = filtered_df.select(split(col("timestamp"), " ").getItem(0).alias("date"), lit(1).alias("count")) reduced_df = mapped_df.groupBy("date").sum("count") reduced_df.count() reduced_df.show() Spark는 실제로 어느 시점에서 데이터 처리를 시작할까요?

Associate-Developer-Apache-Spark-3.5 문제 45

55개 중 39개.

Spark 개발자는 클러스터 전반의 작업 성능을 모니터링하는 Spark 애플리케이션을 개발하고 있습니다.

한 가지 요구 사항은 각 작업자 노드에서 작업에 대한 최대 처리 시간을 추적하고 추가 분석을 위해 이 정보를 드라이버에 통합하는 것입니다.

개발자는 어떤 기술을 사용해야 할까요?

Spark 개발자는 클러스터 전반의 작업 성능을 모니터링하는 Spark 애플리케이션을 개발하고 있습니다.

한 가지 요구 사항은 각 작업자 노드에서 작업에 대한 최대 처리 시간을 추적하고 추가 분석을 위해 이 정보를 드라이버에 통합하는 것입니다.

개발자는 어떤 기술을 사용해야 할까요?