Associate-Developer-Apache-Spark-3.5 문제 61

55개 중 42개.

개발자는 복잡한 Spark 변환 체인의 출력을 events.liveLatest라는 Parquet 테이블에 작성해야 합니다.

이 테이블의 소비자는 event_ts 열(타임스탬프)의 연도와 월에 대한 필터를 사용하여 자주 쿼리를 실행합니다.

현재 코드:

pyspark.sql에서 함수를 F로 가져오기

최종 = df.withColumn("이벤트_년도", F.년도("이벤트_ts")) \

.withColumn("이벤트_월", F.month("이벤트_ts")) \

.bucketBy(42, ["이벤트_년도", "이벤트_월"]) \

.saveAsTable("이벤트.라이브최신")

하지만 소비자들은 쿼리 성능이 좋지 않다고 보고합니다.

어떤 변경 사항을 적용하면 연도 및 월별로 효율적으로 조회할 수 있을까요?

개발자는 복잡한 Spark 변환 체인의 출력을 events.liveLatest라는 Parquet 테이블에 작성해야 합니다.

이 테이블의 소비자는 event_ts 열(타임스탬프)의 연도와 월에 대한 필터를 사용하여 자주 쿼리를 실행합니다.

현재 코드:

pyspark.sql에서 함수를 F로 가져오기

최종 = df.withColumn("이벤트_년도", F.년도("이벤트_ts")) \

.withColumn("이벤트_월", F.month("이벤트_ts")) \

.bucketBy(42, ["이벤트_년도", "이벤트_월"]) \

.saveAsTable("이벤트.라이브최신")

하지만 소비자들은 쿼리 성능이 좋지 않다고 보고합니다.

어떤 변경 사항을 적용하면 연도 및 월별로 효율적으로 조회할 수 있을까요?

Associate-Developer-Apache-Spark-3.5 문제 62

Spark에서 Pandas를 사용하여 데이터 변환을 수행하는 이점은 무엇입니까?

옵션:

옵션:

Associate-Developer-Apache-Spark-3.5 문제 63

다음 코드 조각이 my_spark_app.py에 주어졌습니다.

드라이버 노드의 역할은 무엇인가요?

드라이버 노드의 역할은 무엇인가요?

Associate-Developer-Apache-Spark-3.5 문제 64

데이터 엔지니어는 다음 구성을 사용하여 Spark 클러스터에서 일괄 처리 작업을 실행하고 있습니다.

10개의 워커 노드

워커 노드당 16개의 CPU 코어

노드당 64GB RAM

데이터 엔지니어는 노드당 4개의 실행자를 할당하고, 각 실행자는 4개의 코어를 사용하려고 합니다.

해당 애플리케이션에서 사용되는 CPU 코어의 총 개수는 얼마입니까?

10개의 워커 노드

워커 노드당 16개의 CPU 코어

노드당 64GB RAM

데이터 엔지니어는 노드당 4개의 실행자를 할당하고, 각 실행자는 4개의 코어를 사용하려고 합니다.

해당 애플리케이션에서 사용되는 CPU 코어의 총 개수는 얼마입니까?

Associate-Developer-Apache-Spark-3.5 문제 65

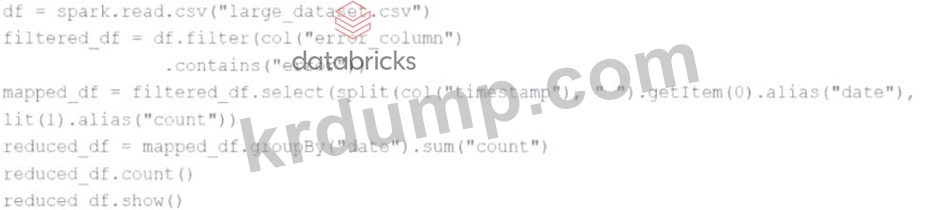

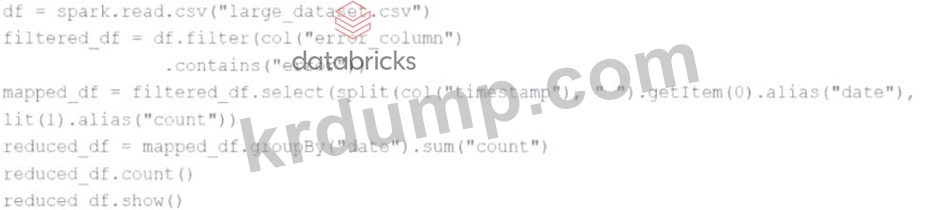

주어진 코드:

df = spark.read.csv("대형 데이터셋.csv")

필터링된_df = df.filter(col("오류_열").포함("오류"))

mapped_df = filtered_df.select(split(col("timestamp")," ").getItem(0).alias("date"), lit(1).alias("count")) reduced_df = mapped_df.groupBy("date").sum("count") reduced_df.count() reduced_df.show() Spark는 실제로 어느 시점에서 데이터 처리를 시작할까요?

df = spark.read.csv("대형 데이터셋.csv")

필터링된_df = df.filter(col("오류_열").포함("오류"))

mapped_df = filtered_df.select(split(col("timestamp")," ").getItem(0).alias("date"), lit(1).alias("count")) reduced_df = mapped_df.groupBy("date").sum("count") reduced_df.count() reduced_df.show() Spark는 실제로 어느 시점에서 데이터 처리를 시작할까요?