DP-203 문제 102

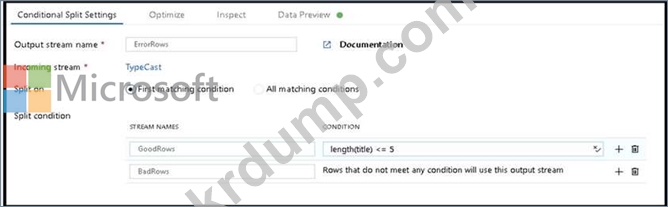

CSV 파일에서 데이터를 수집하고, 열을 지정된 데이터 유형으로 캐스팅하고, Azure Synapse Analytic 전용 SQL 풀의 테이블에 데이터를 삽입하는 Azure Data Factory 데이터 흐름을 만들고 있습니다. CSV 파일에는 사용자 이름, 주석 및 날짜라는 세 개의 열이 있습니다.

데이터 흐름에는 이미 다음이 포함되어 있습니다.

소스 변환.

적절한 데이터 유형을 설정하기 위한 파생 열 변환입니다.

풀에 데이터를 저장하기 위한 싱크 변환입니다.

데이터 흐름이 다음 요구 사항을 충족하는지 확인해야 합니다.

모든 유효한 행은 대상 테이블에 기록되어야 합니다.

주석 열의 잘림 오류는 사전에 방지해야 합니다.

삽입 시 잘림 오류를 발생시키는 주석 값이 포함된 모든 행은 Blob Storage의 파일에 기록되어야 합니다.

어떤 두 가지 작업을 수행해야 합니까? 각 정답은 솔루션의 일부를 나타냅니다.

참고: 각 올바른 선택은 1점의 가치가 있습니다.

데이터 흐름에는 이미 다음이 포함되어 있습니다.

소스 변환.

적절한 데이터 유형을 설정하기 위한 파생 열 변환입니다.

풀에 데이터를 저장하기 위한 싱크 변환입니다.

데이터 흐름이 다음 요구 사항을 충족하는지 확인해야 합니다.

모든 유효한 행은 대상 테이블에 기록되어야 합니다.

주석 열의 잘림 오류는 사전에 방지해야 합니다.

삽입 시 잘림 오류를 발생시키는 주석 값이 포함된 모든 행은 Blob Storage의 파일에 기록되어야 합니다.

어떤 두 가지 작업을 수행해야 합니까? 각 정답은 솔루션의 일부를 나타냅니다.

참고: 각 올바른 선택은 1점의 가치가 있습니다.

DP-203 문제 103

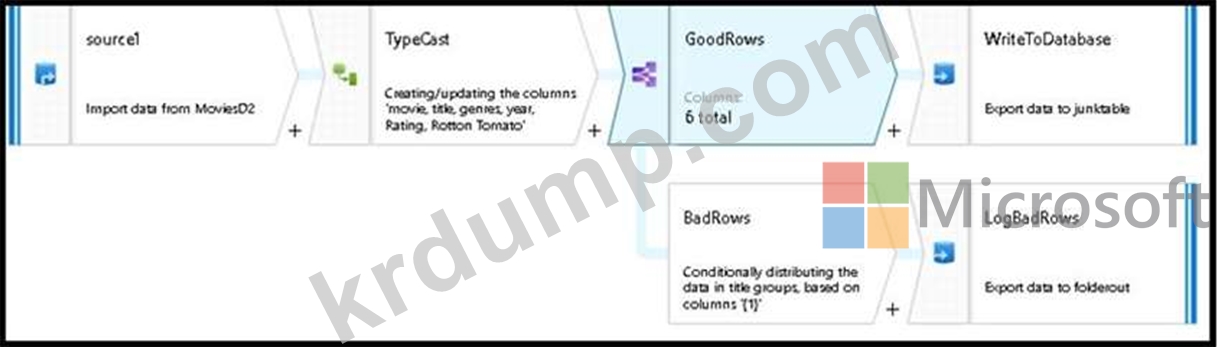

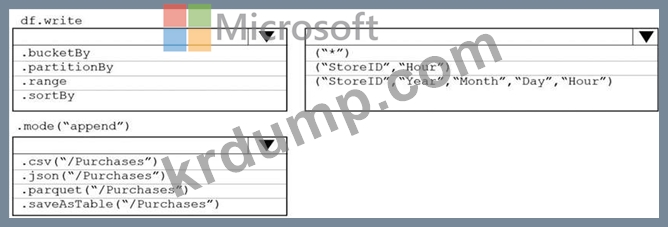

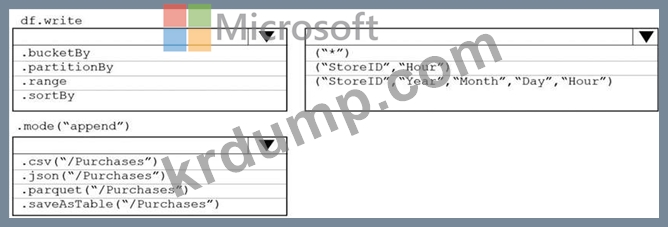

Azure 데이터브릭을 사용하여 Purchases라는 데이터 세트를 개발할 계획입니다. 구매에는 다음 열이 포함됩니다.

* 제품 ID

* 아이템가격

* 라인 총계

* 수량

* StoreD

* 분

* 월

* 시

* 년도

* 낮

각 StoreID에 따라 달라지는 시간별 증분 로드 파이프라인을 지원하려면 데이터를 저장해야 합니다. 솔루션은 스토리지 비용을 최소화해야 합니다. 어떻게 라이드를 완료해야 합니까? 대답하려면 적절한 옵션을 선택하십시오.

참고: 각 올바른 선택은 1점의 가치가 있습니다.

* 제품 ID

* 아이템가격

* 라인 총계

* 수량

* StoreD

* 분

* 월

* 시

* 년도

* 낮

각 StoreID에 따라 달라지는 시간별 증분 로드 파이프라인을 지원하려면 데이터를 저장해야 합니다. 솔루션은 스토리지 비용을 최소화해야 합니다. 어떻게 라이드를 완료해야 합니까? 대답하려면 적절한 옵션을 선택하십시오.

참고: 각 올바른 선택은 1점의 가치가 있습니다.

DP-203 문제 104

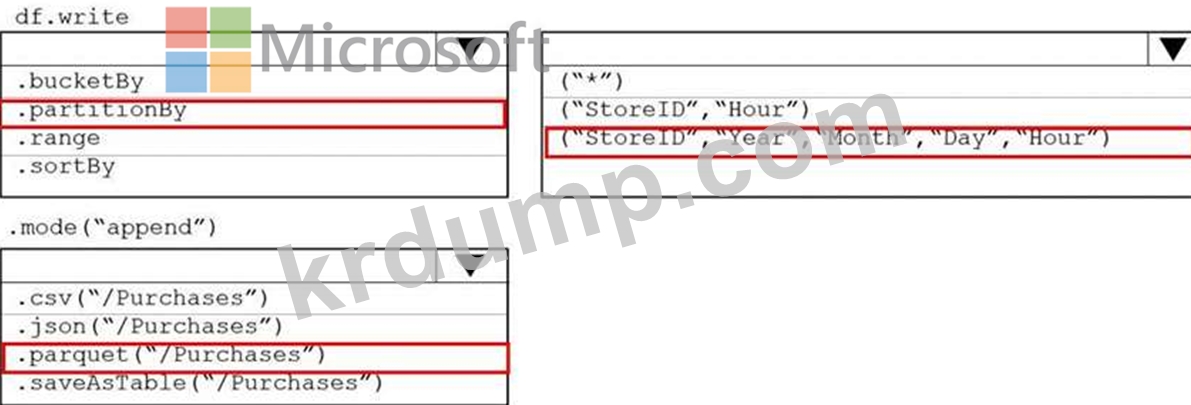

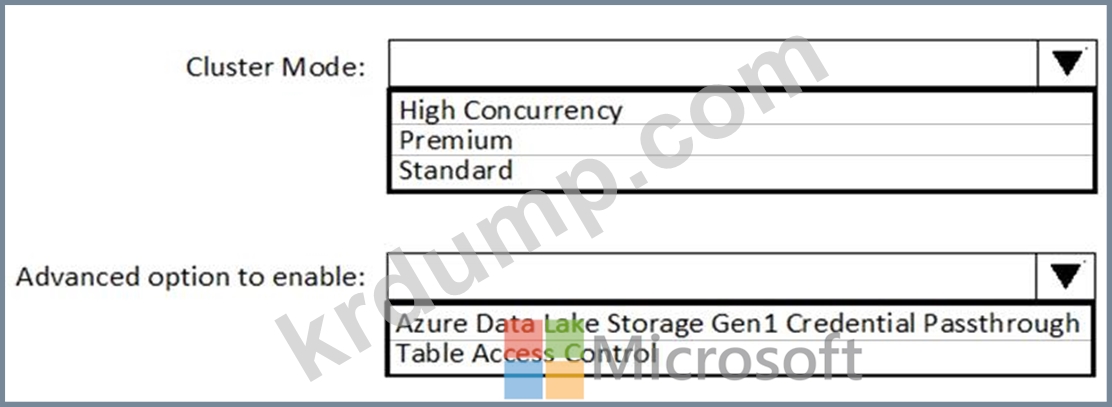

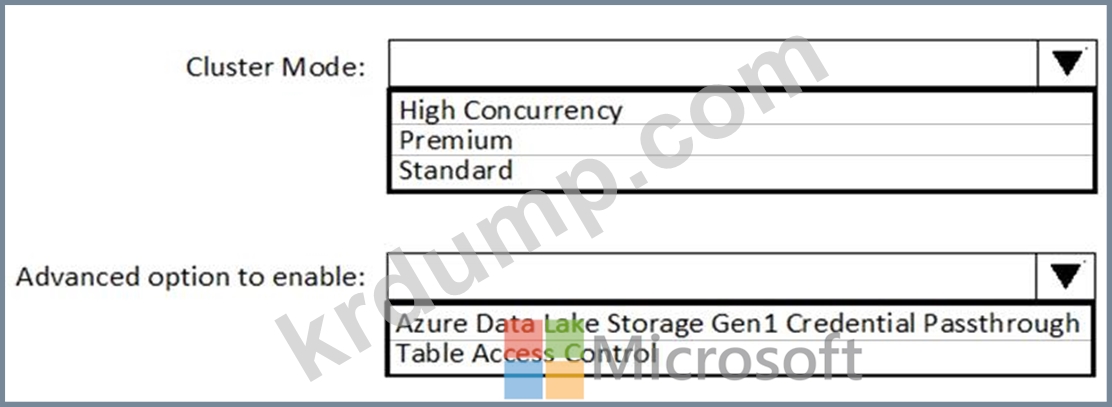

Azure AD(Azure Active Directory) 통합을 사용하여 Azure Data Lake Storage Gen2에 자동으로 연결하는 Azure Databricks 클러스터를 구현해야 합니다.

새 클러스터를 어떻게 구성해야 합니까? 응답하려면 응답 영역에서 적절한 옵션을 선택하십시오.

참고: 각 올바른 선택은 1점의 가치가 있습니다.

새 클러스터를 어떻게 구성해야 합니까? 응답하려면 응답 영역에서 적절한 옵션을 선택하십시오.

참고: 각 올바른 선택은 1점의 가치가 있습니다.

DP-203 문제 105

Azure Synapse Analytics 전용 SQL 풀에서 팩트 테이블에 대한 파티션 전략을 디자인하고 있습니다.

테이블의 사양은 다음과 같습니다.

* 20,000개 제품에 대한 판매 데이터를 포함합니다.

* ProductlID라는 열에 해시 분포를 사용합니다.

* 2019년과 2020년에 대한 24억 개의 레코드를 포함합니다.

클러스터형 columnstore 인덱스의 최적 압축 및 성능을 제공하는 파티션 범위 수는 무엇입니까?

테이블의 사양은 다음과 같습니다.

* 20,000개 제품에 대한 판매 데이터를 포함합니다.

* ProductlID라는 열에 해시 분포를 사용합니다.

* 2019년과 2020년에 대한 24억 개의 레코드를 포함합니다.

클러스터형 columnstore 인덱스의 최적 압축 및 성능을 제공하는 파티션 범위 수는 무엇입니까?

DP-203 문제 106

Azure Data Lake Storage Gen2 계정에 원본 데이터의 증분 로드를 수행하는 Azure Data Factory 파이프라인이 있습니다.

로드할 데이터는 소스 테이블에서 LastUpdatedDate라는 열로 식별됩니다.

4시간마다 파이프라인을 실행할 계획입니다.

파이프라인 실행이 다음 요구 사항을 충족하는지 확인해야 합니다.

동시성 또는 조절 제한으로 인해 파이프라인 실행이 실패하면 자동으로 실행을 재시도합니다.

테이블의 기존 데이터 백필을 지원합니다.

어떤 유형의 트리거를 사용해야 합니까?

로드할 데이터는 소스 테이블에서 LastUpdatedDate라는 열로 식별됩니다.

4시간마다 파이프라인을 실행할 계획입니다.

파이프라인 실행이 다음 요구 사항을 충족하는지 확인해야 합니다.

동시성 또는 조절 제한으로 인해 파이프라인 실행이 실패하면 자동으로 실행을 재시도합니다.

테이블의 기존 데이터 백필을 지원합니다.

어떤 유형의 트리거를 사용해야 합니까?