DP-200 문제 76

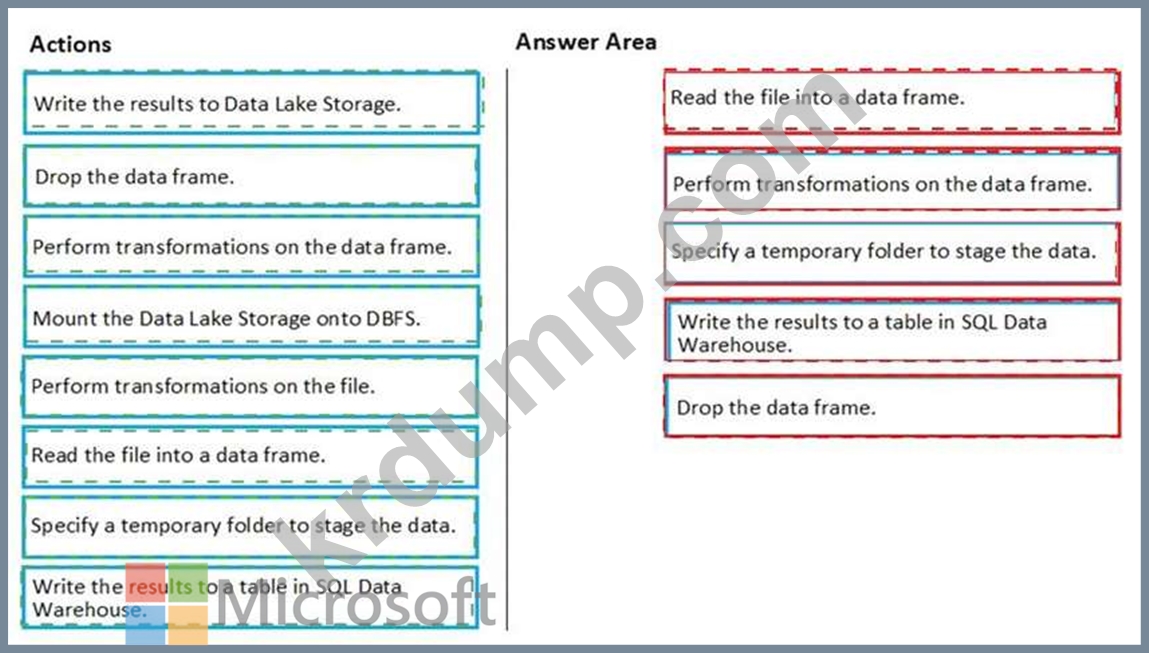

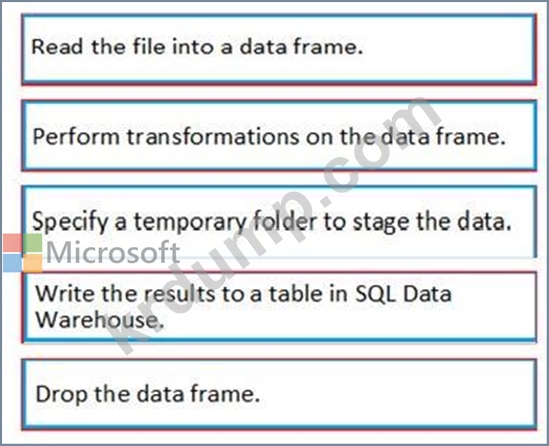

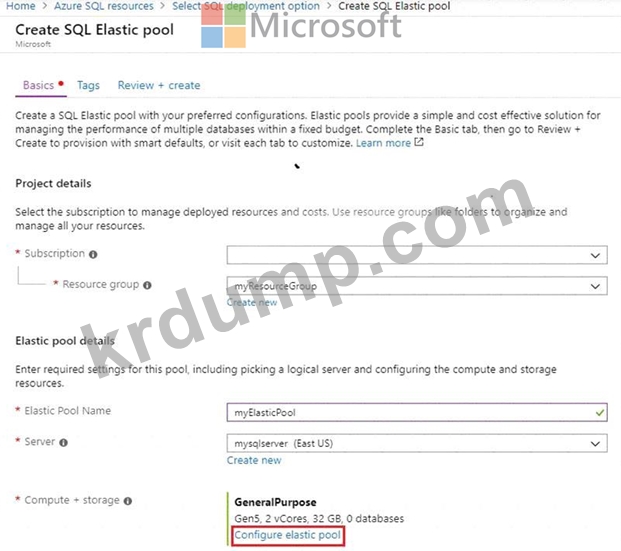

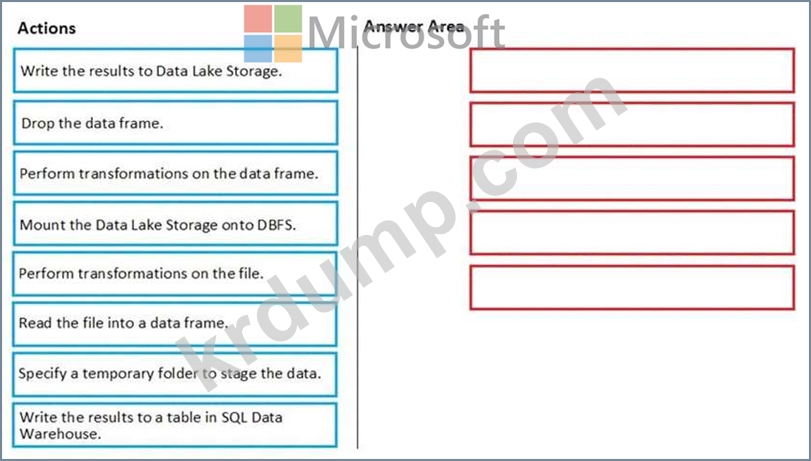

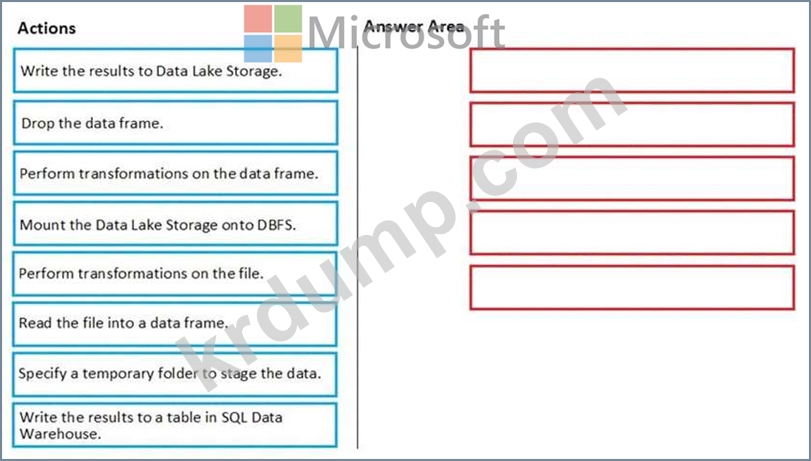

고객용 JSON 파일이 포함된 Azure Data Lake Storage Gen2 계정이 있습니다. 파일에는 FirstName 및 LastName이라는 두 개의 속성이 있습니다.

Azure Databricks를 사용하여 JSON 파일의 데이터를 Azure SQL 데이터 웨어하우스 테이블로 복사해야 합니다. FirstName 및 LastName 값을 연결하는 새 열을 만들어야 합니다.

다음 구성 요소를 만듭니다.

* SQL Data Warehouse의 대상 테이블

* Azure Blob 스토리지 컨테이너

* 서비스 주체

Databricks 노트북에서 다음으로 순서대로 수행해야 하는 5가지 작업은 무엇인가요? 응답하려면 조치 목록에서 해당 조치를 응답 영역으로 이동하고 올바른 순서로 정렬하십시오.

Azure Databricks를 사용하여 JSON 파일의 데이터를 Azure SQL 데이터 웨어하우스 테이블로 복사해야 합니다. FirstName 및 LastName 값을 연결하는 새 열을 만들어야 합니다.

다음 구성 요소를 만듭니다.

* SQL Data Warehouse의 대상 테이블

* Azure Blob 스토리지 컨테이너

* 서비스 주체

Databricks 노트북에서 다음으로 순서대로 수행해야 하는 5가지 작업은 무엇인가요? 응답하려면 조치 목록에서 해당 조치를 응답 영역으로 이동하고 올바른 순서로 정렬하십시오.

DP-200 문제 77

필요에 따라 다음 로그인 자격 증명을 사용합니다.

Azure 사용자 이름: xxxxx

Azure 암호: xxxxx

다음 정보는 기술 지원 목적으로만 사용됩니다.

랩 인스턴스: 10543936

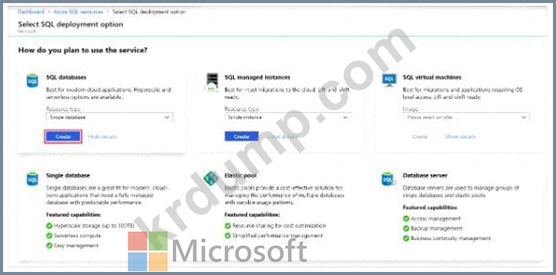

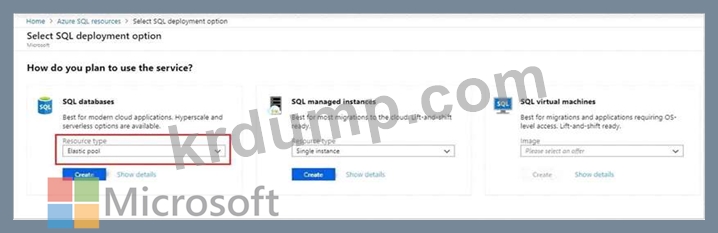

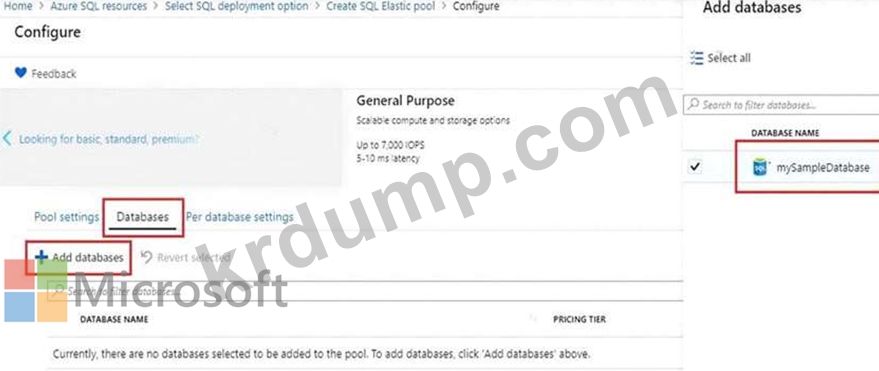

db2라는 Azure SQL 데이터베이스와 db3이라는 새 SQL 데이터베이스를 포함하는 탄력적 풀을 만들어야 합니다.

이 작업을 완료하려면 Azure Portal에 로그인하세요.

Azure 사용자 이름: xxxxx

Azure 암호: xxxxx

다음 정보는 기술 지원 목적으로만 사용됩니다.

랩 인스턴스: 10543936

db2라는 Azure SQL 데이터베이스와 db3이라는 새 SQL 데이터베이스를 포함하는 탄력적 풀을 만들어야 합니다.

이 작업을 완료하려면 Azure Portal에 로그인하세요.

DP-200 문제 78

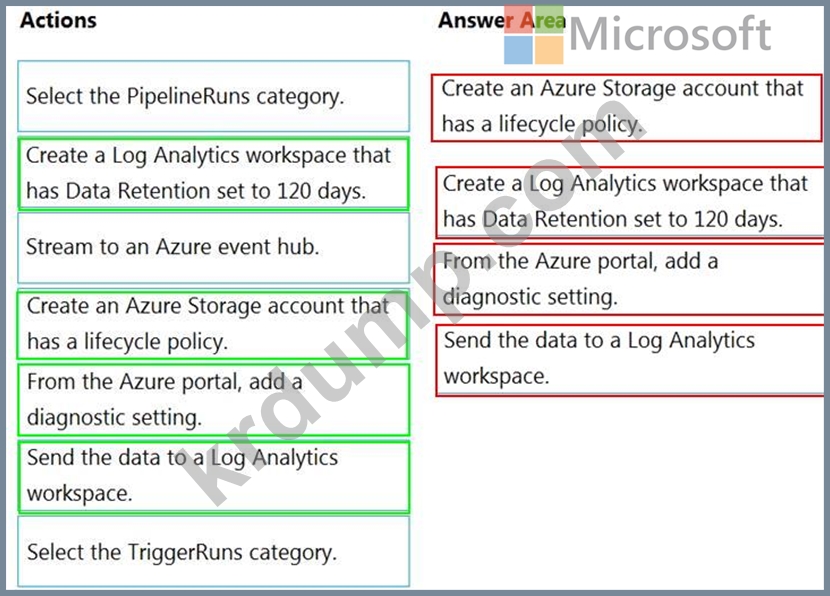

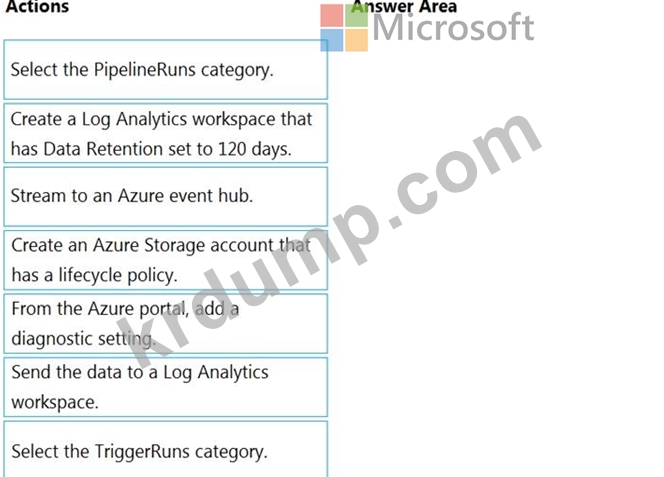

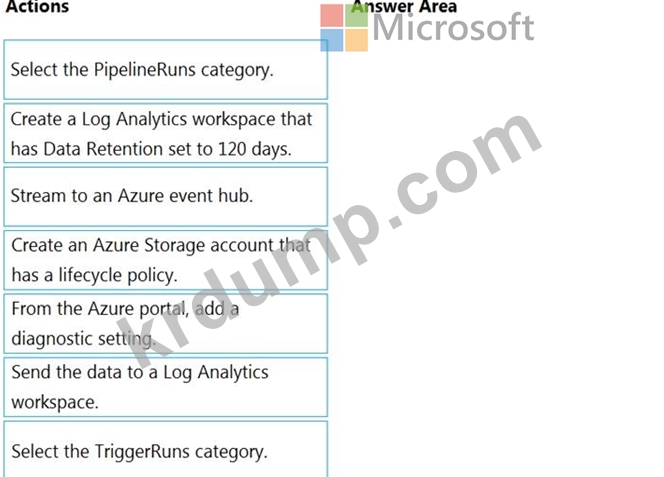

Azure 데이터 팩터리가 있습니다.

파이프라인 실행 데이터가 120일 동안 유지되도록 해야 합니다. 솔루션은 Kusto 쿼리 언어를 사용하여 데이터를 쿼리할 수 있는지 확인해야 합니다.

어떤 4가지 작업을 순서대로 수행해야 합니까? 응답하려면 조치 목록에서 해당 조치를 응답 영역으로 이동하고 올바른 순서로 정렬하십시오.

참고: 둘 이상의 답변 선택 순서가 맞습니다. 선택한 올바른 주문에 대해 크레딧을 받게 됩니다.

파이프라인 실행 데이터가 120일 동안 유지되도록 해야 합니다. 솔루션은 Kusto 쿼리 언어를 사용하여 데이터를 쿼리할 수 있는지 확인해야 합니다.

어떤 4가지 작업을 순서대로 수행해야 합니까? 응답하려면 조치 목록에서 해당 조치를 응답 영역으로 이동하고 올바른 순서로 정렬하십시오.

참고: 둘 이상의 답변 선택 순서가 맞습니다. 선택한 올바른 주문에 대해 크레딧을 받게 됩니다.

DP-200 문제 79

참고: 이 질문은 동일한 시나리오를 제시하는 일련의 질문 중 일부입니다. 시리즈의 각 질문에는 명시된 목표를 충족할 수 있는 고유한 솔루션이 포함되어 있습니다. 일부 질문 세트에는 둘 이상의 올바른 솔루션이 있을 수 있지만 다른 질문 세트에는 올바른 솔루션이 없을 수 있습니다.

이 시나리오에서 질문에 답한 후에는 해당 질문으로 돌아갈 수 없습니다. 결과적으로 이러한 질문은 검토 화면에 나타나지 않습니다.

계층 구조가 있는 Azure Databricks 작업 영역을 만들 계획입니다. 작업 공간에는 다음 세 가지 워크로드가 포함됩니다.

* Python 및 SQL을 사용할 데이터 엔지니어를 위한 워크로드

* Python, Spark, Scala 및 SQL을 사용하는 노트북을 실행할 작업에 대한 워크로드

* 데이터 과학자가 Scala 및 R 엔터프라이즈 아키텍처 팀에서 임시 분석을 수행하는 데 사용할 워크로드는 Databricks 환경에 대해 다음 표준을 식별합니다.

* 데이터 엔지니어는 클러스터를 공유해야 합니다.

* 작업 클러스터는 데이터 과학자와 데이터 엔지니어가 클러스터에 배포할 패키지된 노트북을 제공하는 요청 프로세스를 사용하여 관리됩니다.

* 모든 데이터 과학자는 120분 동안 활동이 없으면 자동으로 종료되는 자체 클러스터를 할당해야 합니다. 현재 3명의 데이터 과학자가 있습니다.

워크로드에 대한 Databrick 클러스터를 생성해야 합니다.

솔루션: 각 데이터 과학자에 대한 높은 동시성 클러스터, 데이터 엔지니어에 대한 높은 동시성 클러스터 및 작업에 대한 표준 클러스터를 만듭니다.

이것이 목표를 달성합니까?

이 시나리오에서 질문에 답한 후에는 해당 질문으로 돌아갈 수 없습니다. 결과적으로 이러한 질문은 검토 화면에 나타나지 않습니다.

계층 구조가 있는 Azure Databricks 작업 영역을 만들 계획입니다. 작업 공간에는 다음 세 가지 워크로드가 포함됩니다.

* Python 및 SQL을 사용할 데이터 엔지니어를 위한 워크로드

* Python, Spark, Scala 및 SQL을 사용하는 노트북을 실행할 작업에 대한 워크로드

* 데이터 과학자가 Scala 및 R 엔터프라이즈 아키텍처 팀에서 임시 분석을 수행하는 데 사용할 워크로드는 Databricks 환경에 대해 다음 표준을 식별합니다.

* 데이터 엔지니어는 클러스터를 공유해야 합니다.

* 작업 클러스터는 데이터 과학자와 데이터 엔지니어가 클러스터에 배포할 패키지된 노트북을 제공하는 요청 프로세스를 사용하여 관리됩니다.

* 모든 데이터 과학자는 120분 동안 활동이 없으면 자동으로 종료되는 자체 클러스터를 할당해야 합니다. 현재 3명의 데이터 과학자가 있습니다.

워크로드에 대한 Databrick 클러스터를 생성해야 합니다.

솔루션: 각 데이터 과학자에 대한 높은 동시성 클러스터, 데이터 엔지니어에 대한 높은 동시성 클러스터 및 작업에 대한 표준 클러스터를 만듭니다.

이것이 목표를 달성합니까?

DP-200 문제 80

회사에는 다양한 클러스터 유형을 사용하여 데이터를 처리하고 분석하는 Microsoft Azure HDInsight 솔루션이 있습니다. 작업은 계속됩니다.

보고서는 특정 기간 동안 속도 저하를 나타냅니다.

최소한의 시간에 문제를 추적하려면 모니터링 솔루션을 결정해야 합니다.

무엇을 사용해야합니까?

보고서는 특정 기간 동안 속도 저하를 나타냅니다.

최소한의 시간에 문제를 추적하려면 모니터링 솔루션을 결정해야 합니다.

무엇을 사용해야합니까?